适用于: Azure 数据工厂

Azure 数据工厂  Azure Synapse Analytics

Azure Synapse Analytics

Azure 数据工厂或 Synapse Analytics 管道中的 HDInsight Hive 活动会在自己的或按需 HDInsight 群集上执行 Hive 查询。 本文基于数据转换活动一文,它概述了数据转换和受支持的转换活动。

如果初次接触 Azure 数据工厂和 Synapse Analytics,请在阅读本文之前,先通读 Azure 数据工厂和 Synapse Analytics 的简介文章,并学习教程:转换数据。

使用 UI 将 HDInsight Hive 活动添加到管道

若要在管道中将 HDInsight Hive 活动用于 Azure Data Lake Analytics,请完成以下步骤:

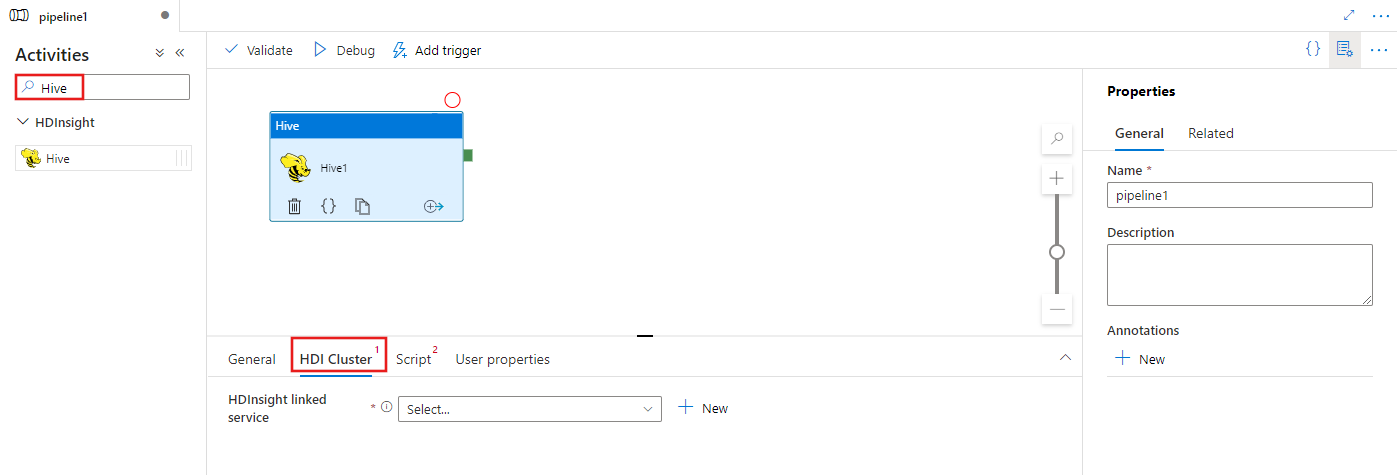

在“管道活动”窗格中搜索“Hive”,然后将 Hive 活动拖到管道画布上。

在画布上选择新的 Hive 活动(如果尚未选择)。

选择“HDI 群集”选项卡以选择或创建新的链接到 HDInsight 群集的服务,该群集将用于执行 Hive 传输活动。

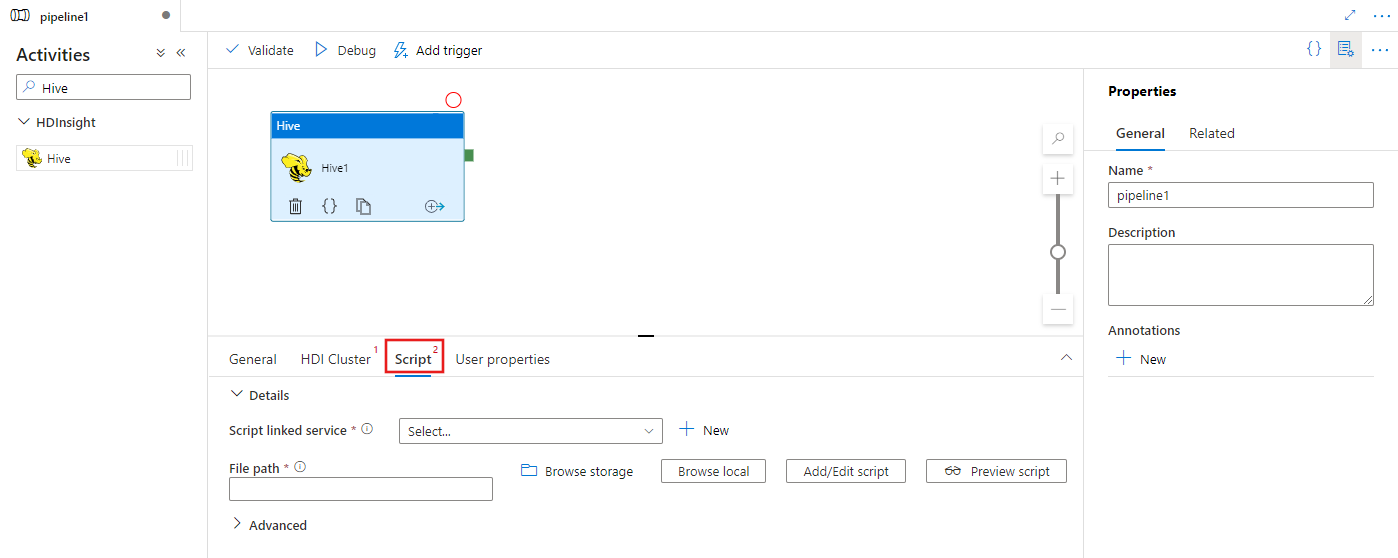

选择“脚本”选项卡以选择或创建新的存储链接服务,并在存储位置中选择一个路径,该路径将承载脚本。

语法

{

"name": "Hive Activity",

"description": "description",

"type": "HDInsightHive",

"linkedServiceName": {

"referenceName": "MyHDInsightLinkedService",

"type": "LinkedServiceReference"

},

"typeProperties": {

"scriptLinkedService": {

"referenceName": "MyAzureStorageLinkedService",

"type": "LinkedServiceReference"

},

"scriptPath": "MyAzureStorage\\HiveScripts\\MyHiveScript.hql",

"getDebugInfo": "Failure",

"arguments": [

"SampleHadoopJobArgument1"

],

"defines": {

"param1": "param1Value"

}

}

}

语法详细信息

| 属性 | 描述 | 必需 |

|---|---|---|

| name | 活动名称 | 是 |

| description | 描述活动用途的文本 | 否 |

| type | 对于 Hive 活动,活动类型是 HDinsightHive | 是 |

| linkedServiceName | 引用注册为链接服务的 HDInsight 群集。 若要了解此链接服务,请参阅计算链接服务一文。 | 是 |

| scriptLinkedService | 对 Azure 存储链接服务的引用,该服务用于存储要执行的 Hive 脚本。 此处仅支持 Azure Blob 存储和 ADLS Gen2 链接服务 。 如果未指定此链接服务,则使用 HDInsight 链接服务中定义的 Azure 存储链接服务。 | 否 |

| scriptPath | 提供由 scriptLinkedService 引用的 Azure 存储中存储的脚本文件的路径。 文件名称需区分大小写。 | 是 |

| getDebugInfo | 指定何时将日志文件复制到 HDInsight 群集使用的(或者)scriptLinkedService 指定的 Azure 存储。 允许的值:None、Always 或 Failure。 默认值:无。 | 否 |

| 参数 | 指定 Hadoop 作业的参数数组。 参数以命令行参数的形式传递到每个任务。 | 否 |

| 定义 | 在 Hive 脚本中指定参数作为键/值对,以供引用。 | 否 |

| queryTimeout | 查询超时值(以分钟为单位)。 适用于 HDInsight 群集已启用企业安全性套餐的情况。 | 否 |

注意

查询超时默认值为 120 分钟。

相关内容

参阅以下文章了解如何以其他方式转换数据: