适用于: Azure 数据工厂

Azure 数据工厂  Azure Synapse Analytics

Azure Synapse Analytics

本文概述了如何在 Azure 数据工厂或 Synapse Analytics 管道中使用复制活动来从 Spark 复制数据。 它是基于概述复制活动总体的复制活动概述一文。

支持的功能

此 Spark 连接器支持以下功能:

| 支持的功能 | IR |

|---|---|

| 复制活动(源/-) | ① ② |

| 查找活动 | ① ② |

① Azure 集成运行时 ② 自承载集成运行时

有关复制活动支持将其作为源/接收器的数据存储列表,请参阅支持的数据存储表。

该服务提供内置的驱动程序用于启用连接,因此使用此连接器无需手动安装任何驱动程序。

先决条件

如果数据存储位于本地网络、Azure 虚拟网络或 Amazon Virtual Private Cloud 内部,则需要配置自承载集成运行时才能连接到该数据存储。

如果数据存储是托管的云数据服务,则可以使用 Azure Integration Runtime。 如果访问范围限制为防火墙规则中允许的 IP,你可以选择将 Azure Integration Runtime IP 添加到允许列表。

此外,还可以使用 Azure 数据工厂中的托管虚拟网络集成运行时功能访问本地网络,而无需安装和配置自承载集成运行时。

要详细了解网络安全机制和数据工厂支持的选项,请参阅数据访问策略。

入门

若要使用管道执行复制活动,可以使用以下工具或 SDK 之一:

使用 UI 创建一个到 Spark 的链接服务

使用以下步骤在 Azure 门户 UI 中创建一个到 Spark 的链接服务。

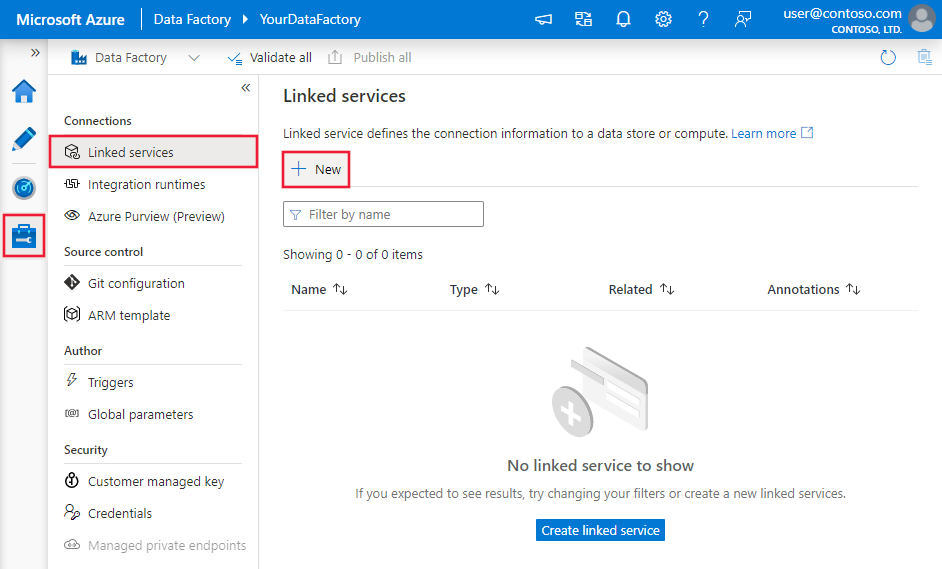

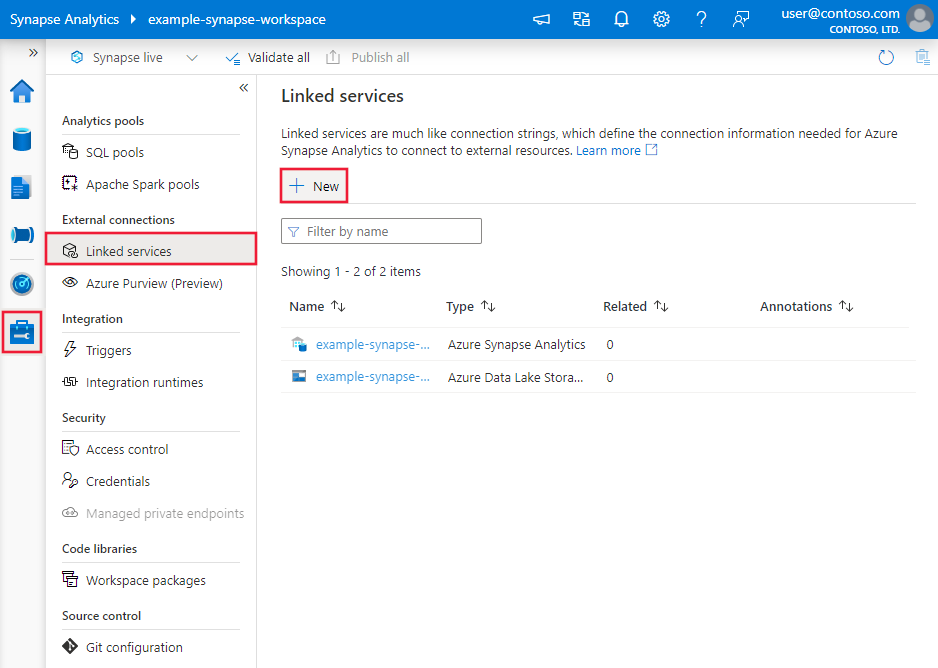

浏览到 Azure 数据工厂或 Synapse 工作区中的“管理”选项卡并选择“链接服务”,然后单击“新建”:

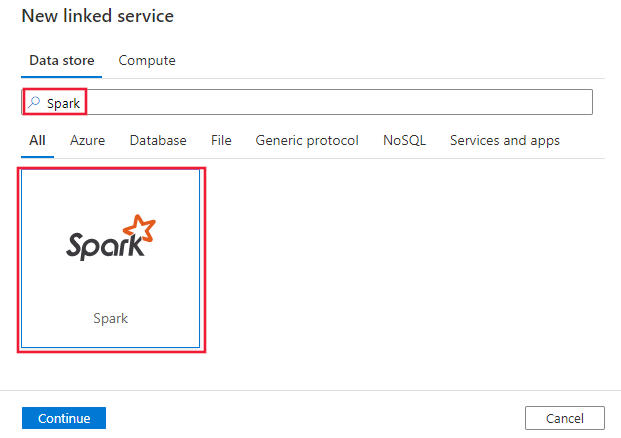

搜索 Spark 并选择 Spark 连接器。

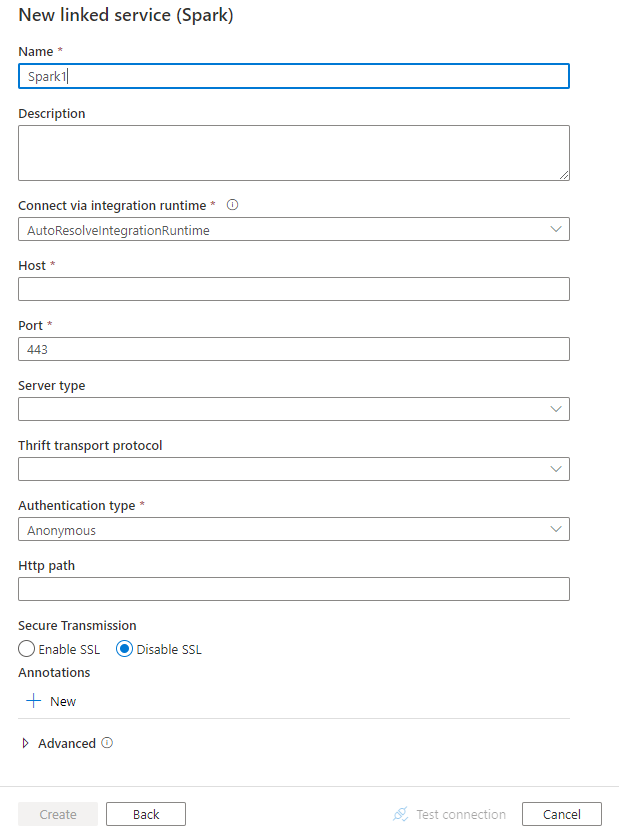

配置服务详细信息、测试连接并创建新的链接服务。

连接器配置详细信息

对于特定于 Spark 连接器的数据工厂实体,以下部分提供有关用于定义这些实体的属性的详细信息。

链接服务属性

Spark 连接器现在支持版本 2.0(预览版)。 请参阅此部分将 Spark 连接器版本从版本 1.0 升级。 关于属性详情,请参阅对应部分。

版本 2.0(预览版)

Spark 链接服务版本 2.0(预览版)支持以下属性:

| 属性 | 描述 | 必需 |

|---|---|---|

| 类型 | type 属性必须设置为:Spark | 是 |

| version | 指定的版本。 该值为 2.0。 |

是 |

| 主机 | Spark 服务器的 IP 地址或主机名 | 是 |

| 端口 | Spark 服务器用来侦听客户端连接的 TCP 端口。 如果连接到 Azure HDInsights,请指定端口 443。 | 是 |

| 服务器类型 | Spark 服务器的类型。 允许的值为:SparkThriftServer |

否 |

| thriftTransportProtocol | Thrift 层中要使用的传输协议。 允许的值为:HTTP |

否 |

| 验证类型 | 用于访问 Spark 服务器的身份验证方法。 允许的值为:Anonymous、UsernameAndPassword、WindowsAzureHDInsightService |

是 |

| 用户名 | 用于访问 Spark 服务器的用户名。 | 否 |

| 密码 | 用户所对应的密码。 将此字段标记为 SecureString 以安全地存储它,或引用 Azure Key Vault 中存储的机密。 | 否 |

| httpPath | 对应于 Spark 服务器的部分 URL。 | 否 |

| 启用SSL | 指定是否使用 TLS 加密到服务器的连接。 默认值为真。 | 否 |

| connectVia | 用于连接到数据存储的集成运行时。 在先决条件部分了解更多信息。 如果未指定,则使用默认 Azure Integration Runtime。 | 否 |

示例:

{

"name": "SparkLinkedService",

"properties": {

"type": "Spark",

"version": "2.0",

"typeProperties": {

"host": "<cluster>.azurehdinsight.cn",

"port": "<port>",

"authenticationType": "WindowsAzureHDInsightService",

"username": "<username>",

"password": {

"type": "SecureString",

"value": "<password>"

}

}

}

}

版本 1.0

Spark 链接服务版本 1.0 支持以下属性:

| 属性 | 描述 | 必需 |

|---|---|---|

| 类型 | type 属性必须设置为:Spark | 是 |

| host | Spark 服务器的 IP 地址或主机名 | 是 |

| 港口 | Spark 服务器用来侦听客户端连接的 TCP 端口。 如果连接到 Azure HDInsights,请指定端口 443。 | 是 |

| 服务器类型 | Spark 服务器的类型。 允许值包括:SharkServer、SharkServer2、SparkThriftServer |

否 |

| thriftTransportProtocol | Thrift 层中要使用的传输协议。 允许值包括:二进制、SASL、HTTP |

否 |

| 认证类型 | 用于访问 Spark 服务器的身份验证方法。 允许的值为:Anonymous、Username、UsernameAndPassword、WindowsAzureHDInsightService |

是 |

| 用户名 | 用于访问 Spark 服务器的用户名。 | 否 |

| 密码 | 用户所对应的密码。 将此字段标记为 SecureString 以安全地存储它,或引用 Azure Key Vault 中存储的机密。 | 否 |

| httpPath | 对应于 Spark 服务器的部分 URL。 | 否 |

| 启用SSL | 指定是否使用 TLS 加密到服务器的连接。 默认值为 false。 | 否 |

| trustedCertPath | 包含受信任 CA 证书(通过 TLS 进行连接时用来验证服务器)的 .pem 文件的完整路径。 只有在自承载 IR 上使用 TLS 时才能设置此属性。 默认值是随 IR 一起安装的 cacerts.pem 文件。 | 否 |

| useSystemTrustStore | 指定是使用系统信任存储中的 CA 证书还是使用指定 PEM 文件中的 CA 证书。 默认值为 false。 | 否 |

| allowHostNameCNMismatch | 指定通过 TLS 进行连接时是否要求 CA 颁发的 TLS/SSL 证书名称与服务器的主机名相匹配。 默认值为 false。 | 否 |

| allowSelfSignedServerCert | 指定是否允许来自服务器的自签名证书。 默认值为 false。 | 否 |

| connectVia | 用于连接到数据存储的集成运行时。 在先决条件部分了解更多信息。 如果未指定,则使用默认 Azure Integration Runtime。 | 否 |

示例:

{

"name": "SparkLinkedService",

"properties": {

"type": "Spark",

"typeProperties": {

"host" : "<cluster>.azurehdinsight.cn",

"port": "<port>",

"authenticationType": "WindowsAzureHDInsightService",

"username": "<username>",

"password": {

"type": "SecureString",

"value": "<password>"

}

}

}

}

数据集属性

有关可用于定义数据集的各部分和属性的完整列表,请参阅数据集一文。 本部分提供 Spark 数据集支持的属性列表。

要从 Spark 复制数据,请将数据集的 type 属性设置为“SparkObject” 。 支持以下属性:

| 属性 | 描述 | 必需 |

|---|---|---|

| 类型 | 数据集的 type 属性必须设置为:SparkObject | 是 |

| schema | 架构的名称。 | 否(如果指定了活动源中的“query”) |

| table | 表的名称。 | 否(如果指定了活动源中的“query”) |

| tableName | 具有架构的表的名称。 支持此属性是为了向后兼容。 对于新的工作负荷,请使用 schema 和 table。 |

否(如果指定了活动源中的“query”) |

示例

{

"name": "SparkDataset",

"properties": {

"type": "SparkObject",

"typeProperties": {},

"schema": [],

"linkedServiceName": {

"referenceName": "<Spark linked service name>",

"type": "LinkedServiceReference"

}

}

}

复制活动属性

有关可用于定义活动的各部分和属性的完整列表,请参阅管道一文。 本部分提供 Spark 数据源支持的属性列表。

Spark 作为源

要从 Spark 复制数据,请将复制活动中的源类型设置为“SparkSource” 。 复制活动source部分支持以下属性:

| 属性 | 描述 | 必需 |

|---|---|---|

| 类型 | 复制活动源的 type 属性必须设置为:SparkSource | 是 |

| query | 使用自定义 SQL 查询读取数据。 例如:"SELECT * FROM MyTable"。 |

否(如果指定了数据集中的“tableName”) |

示例:

"activities":[

{

"name": "CopyFromSpark",

"type": "Copy",

"inputs": [

{

"referenceName": "<Spark input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "SparkSource",

"query": "SELECT * FROM MyTable"

},

"sink": {

"type": "<sink type>"

}

}

}

]

Spark 的数据类型映射

当你从/向 Spark 复制数据时,服务中会使用以下临时数据类型映射。 若要了解复制活动如何将源架构和数据类型映射到接收器,请参阅架构和数据类型映射。

| Spark 数据类型 | 临时服务数据类型(适用于版本 2.0(预览版)) | 临时服务数据类型(适用于版本 1.0) |

|---|---|---|

| BooleanType� | Boolean� | Boolean� |

| ByteType� | Sbyte� | Int16 |

| ShortType� | Int16 | Int16 |

| 整数类型 | Int32 | Int32 |

| LongType� | Int64 | Int64 |

| FloatType� | Single� | Single� |

| DoubleType� | Double� | Double� |

| DateType� | DateTime� | DateTime� |

| 时间戳类型 | DateTimeOffset� | DateTime� |

| 字符串类型 | 字符串 | 字符串 |

| BinaryType� | Byte[]� | Byte[]� |

| DecimalType� | 十进制 | 十进制 |

| 数组类型 | 字符串 | 字符串 |

| StructType� | 字符串 | 字符串 |

| 地图类型 | 字符串 | 字符串 |

| TimestampNTZType� | DateTime� | DateTime� |

| YearMonthIntervalType� | 字符串 | 不支持。 |

| 日时间间隔类型 | 字符串 | 不支持。 |

查找活动属性

若要了解有关属性的详细信息,请查看 Lookup 活动。

升级 Spark 连接器

在“编辑链接服务”页中,选择 2.0 以获取版本,并通过引用链接服务属性版本 2.0(预览版)配置链接服务。

Spark 链接服务版本 2.0(预览版)的数据类型映射与版本 1.0 的数据类型映射不同。 若要了解最新的数据类型映射,请参阅 Spark 的数据类型映射。

Spark 版本 2.0(预览版)与版本 1.0 的差异

Spark 连接器版本 2.0(预览版)提供新的功能,并与版本 1.0 的大多数功能兼容。 下表显示了版本 2.0(预览版)与版本 1.0 的功能差异。

| 版本 2.0 (预览版) | 版本 1.0 |

|---|---|

serverType 不支持 SharkServer 和 SharkServer2。 |

支持 serverType 的 SharkServer 和 SharkServer2。 |

thriftTransportProtocl 不支持二进制和 SASL。 |

支持 thriftTransportProtocl 的二进制和 SASL。 |

| 不支持用户名身份验证类型。 | 支持用户名身份验证类型。 |

enableSSL 的默认值为 true。 不支持 trustedCertPath、useSystemTrustStore、allowHostNameCNMismatch 和 allowSelfSignedServerCert。 |

enableSSL 的默认值为 false。 此外,支持 trustedCertPath、useSystemTrustStore、allowHostNameCNMismatch 和 allowSelfSignedServerCert。 |

| 以下映射用于从 Spark 数据类型到服务内部使用的临时服务数据类型。 TimestampType -> DateTimeOffset YearMonthIntervalType -> 字符串 DayTimeIntervalType -> 字符串 |

以下映射用于从 Spark 数据类型到服务内部使用的临时服务数据类型。 时间戳类型 -> 日期时间 左侧列出的受版本 2.0(预览版)支持的其他映射不受版本 1.0 支持。 |

相关内容

有关复制活动中作为来源和接收器的支持数据存储列表,请参阅支持的数据存储。